matlab нейронная сеть код

Русские Блоги

Как использовать Matlab для анализа нейронной сети BP (включая использование набора инструментов нейронной сети MATLAB)

Перепечатано:https://blog.csdn.net/xgxyxs/article/details/53265318

Как использовать Matlab для анализа нейронной сети BP (в том числе с использованием набора инструментов нейронной сети MATLAB)

Недавно я изучал, как использовать для прогнозирования количества продаж. Я поискал в Интернете и нашел много моделей для прогнозирования, таких как модели регрессии, модели временных рядов, модели GM (1, 1), но я совмещаю реальную работу Содержание, я обнаружил, что точность прогнозирования этих моделей не очень высока, поэтому я поискал в Интернете и обнаружил, что модель нейронной сети может использоваться для прогнозирования, и многие из них комбинируются с временными рядами или SVM (поддержка векторной машины) и другими комбинированными моделями для прогнозирования. Эта статья объединяет фактические данные и выбирает наиболее часто используемый алгоритм нейронной сети BP.Принцип алгоритма обусловлен большим количеством онлайн, поэтому нет необходимости показывать их здесь по одному и ссылаться на него.Исходный код Matlab для прогнозирования трафика с использованием нейронной сети bpЭто сообщение в блоге,Используя Matlab 2016a, дается следующий код и, наконец, делается прогноз

После запуска результаты следующие:

Схема анализа результатов нейронной сети БП

Связь между градиентом обучающих данных и среднеквадратичной ошибкой

Проверьте градиент данных и количество обучения

Диаграмма проверки нормальности остатков (диаграмма Q-Q)

В Интернете я обнаружил, что нейронную сеть можно создать через графический интерфейс инструментария нейронной сети.Общие этапы работы следующие:

1: Введите команду nntool в команде ввода или найдите приложение Netrual Net Fitting в параметрах приложения, щелкните, чтобы открыть, и вы увидите следующий интерфейс

2: Импорт входных и выходных данных (в этой статье выбраны данные case, которые поставляются с Matlab)

3: Случайным образом выберите пропорцию размера выборки трех типов данных, обычно выбирайте значение по умолчанию

4: Подтверждение нейронов скрытого слоя

5: Выбор алгоритма обучения, как правило, выбирайте значение по умолчанию. После завершения выбора нажмите кнопку

6: Согласно полученным результатам, как правило, чем меньше значение MSE, тем ближе значение R к 1, сравнивается эффект его обучения, а на втором рисунке показаны настройки параметров нейронной сети и ее окончательные результаты. Чем ближе R объединенного графика к 1, тем лучше подходит модель.

Изображение окончательного результата

7: Если полученная модель не может удовлетворить ваши потребности, вам необходимо повторить вышеуказанные шаги, пока вы не получите желаемую точность.

8. Сохраните окончательные различные данные и соответствующие значения, а затем просмотрите их, чтобы получить нужные значения.

Функции, связанные с MATLAB и нейронными сетями, кратко изложены следующим образом:

Нужен код для нейронной сети

Нужен код в матлабе для комбинированной ИНС. Нейронная сеть, созданная по такому принципу, обладает задержками, как по входу, так и по выходу.

| Комментарий модератора | ||

| ||

Помощь в написании контрольных, курсовых и дипломных работ здесь.

Сегментация изображения для обучения нейронной сети

Здравствуйте. Я разрабатываю нейронную сеть для диагностики двигателя автомобиля по.

Как сохранит мытрицу весов для нейронной сети в matlab

Всем здравствуйте! У меня есть вопрос о том, каким образом я могу сохранить матрицу весов нейронной.

Обучение нейронной сети для получения аппроксимирующей модели зависимости

Помогите написать код программы, а то плохо понимаю тему, да и сети в принципе. Задание: По.

Нужна программа на основе нейронной сети для распознавания букв.

пожалуйста, помогите! нужна программа на основе нейронной сети для распознавания букв. на вход.

Digiratory

Лаборатория автоматизации и цифровой обработки сигналов

Нейронные сети в MatLab

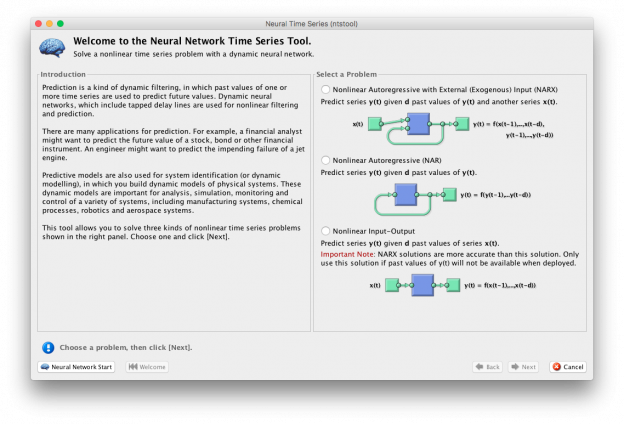

В этой статье мы рассмотрим возможности использования одного из основных инструментов MatLab для проектирования и обучения нейронных сетей Neural Time Series (ntstool) как с помощью GUI, так и с помощью программного кода (а также коснемся расширения возможностей проектирования с помощью программного кода)

Выбор типа сети

Рис. 1 – Экран приветствия утилиты ntstool

При запуске утилиты ntstool пользователя встречает экран приветствия со следующем текстом приветствия:

Предсказание — это своего рода динамическая фильтрация, в которой прошлые значения одного или нескольких временных рядов используются для прогнозирования будущих значений. Динамические нейронные сети, которые включают в себя слои запаздывания, используются для нелинейной фильтрации и прогнозирования.

Существует много приложений для прогнозирования. Например, финансовый аналитик может захотеть предсказать будущую стоимость акции, облигации или другого финансового инструмента. Инженер может захотеть предсказать сбой реактивного двигателя.

Предиктивные модели также используются для идентификации системы (или динамического моделирования), в котором строятся динамические модели физических систем. Эти динамические модели используются для анализа, моделирования, мониторинга и управления различными системами, включая производственные системы, химические процессы, робототехнику и аэрокосмические системы.

Этот инструмент позволяет решать три типа нелинейных временных рядов, показанных на правой панели. Выберите одно и нажмите [Next].

На правой панели находится панель выбора типа нейронной сети:

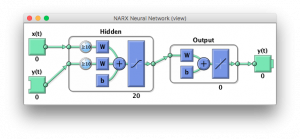

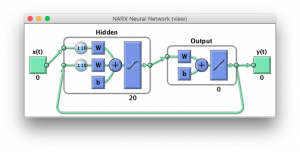

Однако с помощью программного кода можно реализовать большее количество архитектур сети, например:

1. Нелинейная авторегрессионная с внешним входом:

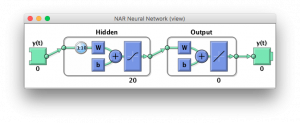

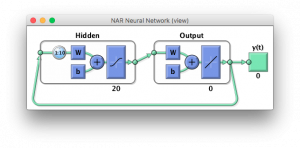

Является реализацией одного из простейших типов нейронных сетей, в частности, сетей прямого распространения, однако реализуется временное окно получения данных.

Для генерации с помощью программного кода нужно использовать следующую команду:

С помощью команды closeloop(net), есть возможность замкнуть контур этой сети для получения рекуррентной сети.

2. Нелинейная вход-выход (Без обратных связей ):

Реализует простейшую сеть прямого распространения.

Для генерации с помощью программного кода нужно использовать следующую команду:

С помощью команды closeloop(net), есть возможность замкнуть контур этой сети для получения рекуррентной сети — генератора.

Пример создания нейронных сетей с помощью кода

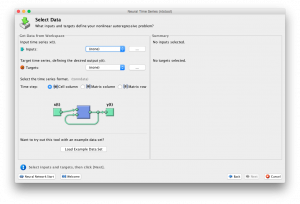

Выбор данных для обучения, и их подготовка

Рис. 6 – Окно выбора параметров

В утилите ntstool выбор данных для обучения не составляет проблем, поэтому рассмотрим выбор параметров в коде:

Прежде чем начать, разберемся что такое подготовка данных (Из официальной документации):

Подготовка данных для обучения и имитации. Функция PREPARETS подготавливаем временные ряды для части сети, изменяя время до минимума, чтобы “чувствовать” входные данные и внутренние переменные. Использование PREPARETS позволяет оставить исходные временные ряды неизменными, легко настраивая их для сети с разными размерами задержек как для открытых, так и закрытых нейронных сетей.

Также, перед применение preparets может потребоваться использование функции tonndata, которая конвертирует данные в стандартный тип для нейронных сетей.

Синтаксис команды tonndata:

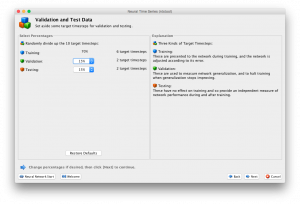

Выбор назначения данных

В этой части рассматривается выбор процентного соотношения данных: Тренировка, Проверка, Тестирование

Рис. 7 – Окно выбора процентного соотношения

Как и предыдущие шаги, работа с ntstool очень проста и требует простого выбора значений. В том случае, если вы проектируете нейронную сеть с помощью программного кода используйте следующие команды:

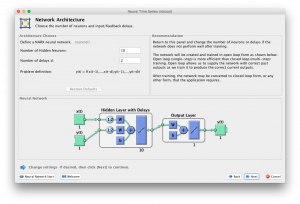

Выбор количества скрытых нейронов и задержек

Последним шагом перед обучением сети в ntstool является выбор количества скрытых нейронов и количество нейронов задержки.

Рис. 8 – Окно выбора размера сети

Заметим, что размеры сети при проектировании в программном кде определяются на первом шаге.

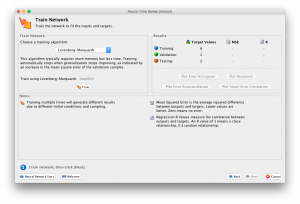

Обучение нейросети

Рис. 9 – Окно обучения нейронной сети

Операция обучения кодом выглядит так:

Для обучения сети в обоих случаях используется nntraintool:

Рис.10 — Окно nntraintool

При помощи которого можно получить различные графики, характеризующие процесс и качество обучения сети.

Графики также можно вызывать с помощью команд:

Для более подробной информации о дополнительных возможностях train, воспользуйтесь официальным руководством (возможностей там много).

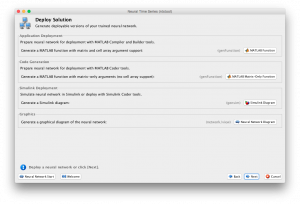

Получение нейронной сети

Для работы с обученной сетью необходимо выполнить экспорт полученной нейросети.

Рис. 11 — Окно экспорта нейронной сети

Главный вопрос, который встает на этом шаге: можно ли установить конкретное время дискретизации для нейронной сети. Ответ: да можно, но не с использованием ntstool, где всегда по будет шаг дискретизации 1 секунда.

Для получения Simulink модели после всех операций над нейронной сетью с использованием кода, необходимо вызвать функцию :

где time – время дискретизации, а net – нейронная сеть.

После вызова будет получена модель в Simulink, с заданной частотой дискретизации.

Примерный программный код для проектирования простейшей нейронной сети в MatLab

Ефименко Г.А., Синица А.М.: Нейронные сети в MatLab [Электронный ресурс] // Digiratory. 2017 г. URL: https://digiratory.ru/508 (дата обращения: ДД.ММ.ГГГГ).

Нейронные сети в MatLab : 5 комментариев

Георгий, здравствуйте! А как масштабировать входные данные?

В графическом интерфейсе размерность входа определяется автоматически исходя из размерности матрицы входных значений, в случае с описанием в формате кода, то размерностью входных данных для функции tonndata(x,columnSamples,cellTime).

нужна помощь в создании нс

Опишите, пожалуйста, свою проблему. Мы попробуем помочь.

если можно не здесь, а по почте ***@mail.ru

Добавить комментарий Отменить ответ

Для отправки комментария вам необходимо авторизоваться.

Свойства и параметры нейронной сети как объекта MATLAB

Архитектура сети

Эти свойства определяют количество подобъектов сети (таких как слои, выходы, эталоны, смещения и веса), и каким образом они объединяются в сеть.

Количества входов сети и размерность входа разные вещи. Количество входов определяет, сколько групп векторов принимает сеть в качестве входов. Размерность каждого входа (т.е. количество элементов в каждом векторе) определяется размерностью входа (net.inputs.size). Большинство сетей имеет один вход, размерность которого определяется поставленной задачей.

Любое изменение этого свойства приводит к изменению размера матрицы, определяющей связи входов со слоями, (net.inputConnect) и размер массива ячеек входных подобъектов (net.inputs).

Любое изменение этого свойства приводит к изменению размера каждой из булевых матриц, которые определяют связи между слоями:

и изменяют размерности каждого из массивов ячеек структур подобъектов, чьи размеры зависят от количества слоев:

А также изменяет размеры каждого из настраиваемых параметров:

Любое изменение этого свойства влияет на наличие или отсутствие структур в массиве ячеек смещений (net.biases) и, в наличии или отсутствии в массиве элементов векторов смещений (net.b).

net.inputConnect – определяет Булеву матрицу Nl x Ni, где Nl – количество слоев сети (net.numLayers), а Ni – количество входов сети (net.numInputs). Наличие (или отсутствие) связи i – го слоя с j – м слоем определяется 1 (или 0) в net.inputConnect(i,j).

Любое изменение этого свойства влияет на наличие или отсутствие структур в массивах ячеек подобъектов входных весов (net.inputWeights) и на наличие или отсутствие матриц в массиве ячеек входных весов (net.IW).

Любое изменение этого свойства влияет на наличие или отсутствие структур в массивах ячеек подобъектов весов слоев (net.layerWeights) и в наличии или отсутствии матриц в массиве ячеек весов слоев (net.LW).

Любые изменения этого свойства будут влиять на количество выходов сети (net.numOutputs) и наличие или отсутствие структур в массиве ячеек выходных подобъектов (net.outputs).

Любые изменения этого свойства будут изменять количество эталонных значений сети (net.numTargets) и наличие или отсутствие структур в массиве ячеек эталонных подобъектов (net.targets).

Структура подобъектов

Эти свойства определяют массивы ячеек структур, которые определяют каждый из входов сети, слои, выходы, эталоны, смещения и веса.

Структура, определяющая свойства i-го сетевого входа, определена в: net.inputs

Структура, определяющая свойства i-го слоя определена в: net.layers.

Структура, определяющая свойства i-го выхода, определена в: net.outputs

если соответствующее выходное соединение net.outputConnect(i)- 1 (или 0):.

net.targets – массив 1xNi ячеек входных структур, где Ni- число слоев сети (net.numLayers).

inputWeights – содержит структуры свойств для каждого из входных весов.

Функции

Эти свойства определяют алгоритмы, которые используются при адаптации, инициализации, тренировке и оценке ее функционирования.

trains – функция адаптации весов и смещений.

Функция адаптации сети используется, чтобы выполнить адаптацию всякий раз, когда вызывается adapt:

Всякий раз, когда это свойство изменено, параметры адаптации сети (net.adaptParam) устанавливаются таким образом, чтобы содержать параметры и значения по умолчанию новой функции.

Функция инициализации сети используется, чтобы выполнить инициализацию всякий раз, когда вызывается init:

Всякий раз, когда это свойство изменено, параметры сети (net.initParam) устанавливаются таким образом, чтобы содержать параметры и значения по умолчанию новой функции.

performFcn – определяет функцию, используемую для оценки функционирования сети.

| Функции функционирования | |

| mae | Средняя абсолютная ошибка |

| mse | Средняя квадратичная ошибка |

| msereg | Средняя квадратичная ошибка w/reg |

| sse | Суммарная квадратичная ошибка |

Функция функционирования сети используется, чтобы вычислить оценку функционирования сети всякий раз, когда вызывается train:

Всякий раз, когда это свойство изменено, параметры сети (net.performParam) устанавливаются таким образом, чтобы содержать параметры и значения по умолчанию новой функции.

| Функции тренировки | |

| trainb | Пакетная тренировка с использованием правил обучения для весов и смещений |

| trainbfg | Тренировка сети с использованием квази –Ньютоновского метода BFGS |

| trainbr | Регуляризация Bayesian |

| trainc | Использование приращений циклического порядка |

| traincgb | Метод связанных градиентов Пауэлла-Била (Powell-Beale) |

| traincgf | Метод связанных градиентов Флетчера-Пауэлла (Fletcher-Powell) |

| traincgp | Метод связанных градиентов Полака-Рибира (Polak-Ribiere) |

| traingd | Метод градиентного спуска |

| traingda | Метод градиентного спуска с адаптивным обучением |

| traingdm | Метод градиентного спуска с учетом моментов |

| traingdx | Метод градиентного спуска с учетом моментов и с адаптивным обучением |

| trainlm | Метод Левенберга-Маркара (Levenberg-Marquardt) |

| trainoss | Одноступенчатый метод секущих |

| trainr | Метод случайных приращений |

| trainrp | Алгоритм упругого обратного распространения |

| trains | Метод последовательных приращений |

Функция используется, чтобы тренировать сеть всякий раз, когда вызывается train:

Всякий раз, когда это свойство изменено, параметры сети (net.trainParam) устанавливаются таким образом, чтобы содержать параметры и значения по умолчанию новой функции.

Параметры

Вызовите help на текущую функцию адаптации, чтобы получить описание каждого из полей: help(net.adaptFcn).

Вызовите help на текущую функцию инициализации, чтобы получить описание каждого из полей: help(net.initFcn)

Вызовите help на текущую функцию функционирования, чтобы получить описание каждого из полей: help(net.performFcn)

Вызовите help на текущую функцию тренировки, чтобы получить описание каждого из полей: help(net.trainFcn)

Значения весов и смещений

Эти свойства определяют модифицируемые параметры сети: матрицы весов и векторы смещений.

net.IW – массив NlxNi ячеек, где Nl- число слоев в сети (net.numLayers), а Ni- число входов сети (net.numInputs).

Матрица весов для связи i го слоя с j м входом (или нулевая матрица []) описывается в: net.IW

Матрица весов имеет количество строк, равное размеру слоя, к которому она относится (net.layers.size). Содержит количество столбцов равное произведению размерности входа на количество задержек, ассоциированных с весом:

Эти размеры могут также быть получены из свойств входных весов:

Матрица весов имеет количество строк, равное размеру слоя, к которому она относится (net.layers.size). Содержит количество столбцов равное произведению размерности слоя на количество задержек, ассоциированных с весом:

Эти размеры могут также быть получены из свойств веса слоя:

Вектор смещения для i-го слоя (или нулевая(пустая) матрица []) определен в net.b если соответствующее соединение смещения net.biasConnect(i)- 1 (или 0).

Число элементов в векторе смещения всегда равно размеру слоя, с которым он связан (net.layers.size). Этот размер может также быть получен из свойств смещения: net.biases.size.

Другие свойства

Только одно поле предопределено. Оно содержит секретное сообщение всем пользователям Neural Network Toolbox:

Русские Блоги

Использование Matlab (11) нейронной сети

Искусственная нейронная сеть

Искусственные нейронные сети в основном используются для моделирования данных, прогнозирования, распознавания образов и оптимизации функций.

1. Основная теория

ANN (искусственная нейтральная сеть, искусственная нейронная сеть) представляет собой сложную сетевую систему, которая состоит из большого числа простых базовых элементов-нейронов, соединенных друг с другом, путем имитации обработки информации нервом мозга человека, параллельной обработки информации и нелинейного преобразования.

1. Основные математические основы сети БП

2. Панель инструментов

1. Функция создания сети БП

Возможные переменные и их значения:

| переменная | смысл |

|---|---|

| PR | R X 2 матрица, состоящая из максимального и минимального значений каждого набора входных элементов |

| Si | первый i » role=»presentation»> i Длина слоя, всего N » role=»presentation»> N слой |

| TFi | первый i » role=»presentation»> i Функция возбуждения слоя, по умолчанию «tansig» |

| BTF | Функция обучения по сети, по умолчанию «trainlm» |

| BLF | Алгоритм обучения для весов и пороговых значений, по умолчанию «Learningngdm» |

| PF | Функция производительности сети, по умолчанию «mse» |

1. Функция newcf

Эта функция используется для создания сети BP

Среди них net = newff используется для создания сети BP в диалоговом окне.

2. Функция newfftd

Эта функция используется для создания прямой сети с задержкой на вход

Среди них net = newfftd используется для создания сети BP в диалоговом окне.

2. Функция возбуждения нейрона

Функция возбуждения должна быть непрерывно дифференцируемой

1. Функции журнала

| кодовое значение | Информация возвращена |

|---|---|

| ‘deriv’ | Имя дифференциальной функции |

| ‘name’ | Полное имя функции |

| ‘output’ | Диапазон выхода |

| ‘active’ | Допустимый интервал ввода |

Алгоритм, используемый этой функцией:

2. Функция журнала

dlogsig является производной функцией logsig

Алгоритм, используемый этой функцией:

3. Функция тансиг

Алгоритм, используемый этой функцией:

4. Функция dtansig

Алгоритм, используемый этой функцией:

5. Функция purelin

Алгоритм, используемый этой функцией:

6. Функция дпурелин

Алгоритм, используемый этой функцией:

3. Функция обучения сети BP

1. Функция Learning

| кодовое значение | Информация возвращена |

|---|---|

| pnames | Вернуться к заданным параметрам обучения |

| pdefaults | Возвращает параметры обучения по умолчанию |

| needg | Если функция использует gW или gA, она возвращает 1 |

2. Функция learningngdm

Значение каждого параметра такое же, как learnngdm, а постоянная импульса mc задается параметром обучения LP, формат LP.mc = 0,8

4. Функция обучения сети BP

1. Функция trainbfg

Функция trainbfg является функцией квазиньютоновского алгоритма BP BFGS. В дополнение к сети BP эта функция может также обучать любую форму нейронной сети, требуя, чтобы ее функция возбуждения имела производные по весам и входам

| кодовое значение | Информация возвращена |

|---|---|

| pnames | Вернуться к заданным параметрам обучения |

| pdefaults | Возвращает параметры обучения по умолчанию |

При использовании этой функции для обучения сети BP, Matlab уже установил по умолчанию некоторые параметры обучения, как показано в таблице:

| Имя параметра | Значение по умолчанию | собственности |

|---|---|---|

| net.trainParam.epochs | 100 | Количество тренировок, количество тренировок, установленных вручную, не может превышать 100 |

| net.trainParam.show | 25 | Количество тренировочных шагов между дисплеями |

| net.trainParam.goal | 0 | Тренировочная цель |

| net.trainParam.time | inf | Время обучения, inf означает неограниченное время обучения |

| net.trainParam.min_grad | 1e-6 | Минимальный градиент производительности |

| net.trainParam.max_fail | 5 | Максимальное количество ошибок подтверждения |

| net.trainParam.searchFcn | ‘srchcha’ | Используется линейный путь поиска |

2. Функция traingd

Функция traingd является обучающей функцией алгоритма градиентного спуска BP

Значение, формат настройки и диапазон использования каждого параметра вышеупомянутой программы совпадают с функцией trainbfg

3. Функция traingdm

Функция traingdm является обучающей функцией алгоритма BP градиентного спуска

Значение, формат настройки и диапазон использования каждого параметра вышеупомянутой программы совпадают с функцией trainbfg

5. Производительность

1. Функция мсе

Функция mse является среднеквадратичной погрешностью

| кодовое значение | Информация возвращена |

|---|---|

| deriv | Возвращает имя производной функции |

| name | Возвращаем полное имя функции |

| pnames | Возвращает название функции обучения |

| pdefaults | Возвращает функцию обучения по умолчанию |

2. Функция мсерег

Значение каждого параметра в вышеприведенной программе совпадает со значением функции mse.

Функция msereg заключается в добавлении среднеквадратичной ошибки весов и порогов сети на основе функции mse, цель состоит в том, чтобы заставить сеть получать меньшие веса и пороги, тем самым заставляя отклик сети становиться более плавным

3. Меры предосторожности при формировании нейронной сети

1. Количество нейронных узлов

Количество входных и выходных узлов сети определяется размером фактической проблемы и не имеет никакого отношения к производительности сети. Расчет числа узлов L скрытого слоя очень важен и обычно может быть определен с использованием одной из следующих двух эмпирических формул

Среди них m 、 n » role=»presentation»> m 、 n Соответственно, количество входных узлов и количество выходных узлов; a » role=»presentation»> a Постоянная между 1

Количество скрытых узлов может быть получено из начального значения в соответствии с двумя вышеупомянутыми формулами, и затем число нейронов может быть окончательно определено методом ступенчатого роста или пошагового сокращения. Постепенный рост начинается с более простой сети: если результат обучения не соответствует требованиям, постепенно увеличивайте количество нейронов скрытого слоя до тех пор, пока он не станет подходящим, постепенное сокращение начинается с более сложной сети и постепенно удаляет нейроны скрытого слоя

2. Предварительная обработка данных и последующая обработка

Методы предварительной обработки, предоставляемые в MATLAB, следующие:

1. Функция premnmx

Функция нормализации premnmx

Где р R × Q » role=»presentation»> R × Q Размерная матрица ввода; pn стандартизирован R × Q » role=»presentation»> R × Q Размер входной матрицы; minp R × 1 » role=»presentation»> R × 1 Измерение содержит вектор минимального значения каждого компонента p; maxp равен R × 1 » role=»presentation»> R × 1 Размерность содержит вектор максимального значения каждого компонента p; tn нормируется S × Q » role=»presentation»> S × Q Размерная целевая матрица; мята S × 1 » role=»presentation»> S × 1 Измерение содержит каждый компонент t; maxt является S × 1 » role=»presentation»> S × 1 Размер содержит вектор максимального значения каждого компонента t

Алгоритм, используемый этой функцией:

4. Примеры

Описание проблемы

Дорожное движение в основном включает автомобильные пассажирские перевозки и автомобильные грузовые перевозки. Согласно исследованиям, объем дорожного движения в определенном районе в основном связан с количеством людей в этом районе, количеством автомобилей и площадью дорог.

Согласно данным соответствующих департаментов, число людей в регионе в 2010 и 2011 годах составило 733 900 и 755 500 человек соответственно, количество автомобилей составило 3,9635 и 40 975 000 человек соответственно, а площадь дороги составит 0,9880 и 1,0268 миллиона квадратных километров соответственно.

Пожалуйста, используйте сеть BP, чтобы прогнозировать автомобильные пассажирские и автомобильные перевозки в регионе в 2010 и 2011 годах.